在大模型和生成式AI浪潮下,英伟达面向数据中心的产品A100、H100产品备受瞩目,几乎是大模型、云计算公司的唯一选择。

为了不受制于英伟达,AMD、英特尔等芯片厂商正寻求在人工智能市场占有一席之地,微软、谷歌、OpenAI 等会大批采购AI芯片的企业,则寻求自研芯片。

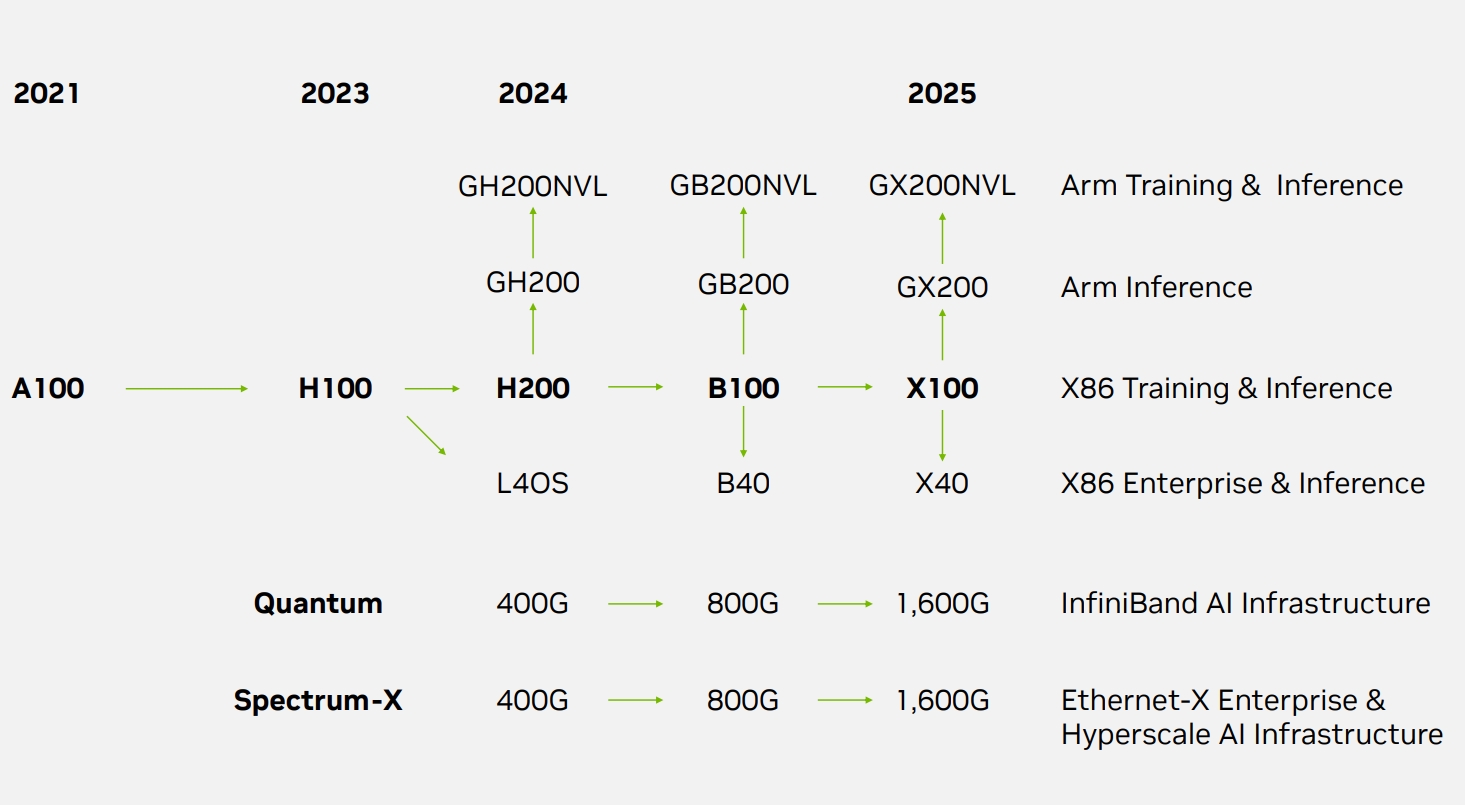

竞争对手林立,英伟达也正不断推动产品研发和加快更新迭代速度。近日,据servethehome等外媒披露了英伟达的数据中心产品路线图,展示了英伟达面向人工智能市场的产品规划,将推出H200、B100 和 "X100"等多款GPU。

英伟达未来产品规划

如今,英伟达的A100、H100芯片一卡难求,无论是企业级客户还是消费级客户,都只能抢购A100、H100产品来完成大模型的训练。

英伟达正计划增加面向数据中心市场的产品种类,推出多款面向AI计算和HPC的产品,让不同的客户可以有针对性购买产品,降低购买芯片难度。

通过架构图可以看到,未来英伟达将会对基于 Arm 架构的产品和基于x86架构的产品分开。

2024年推出的H200h和L40S仍基于x86架构设计。H200是对H100的重新设计, NVIDIA的 H100 拥有 80GB 的 HBM3 内存,H200的内存容量会增加3.5倍,带宽会增加3倍,且拥有282GB 的HBM3e内存。

L40S则是面向企业级客户的推理芯片,配备 48GB GDDR6 显存和 64GB/s 的双向显存带宽,在在FP64和FP32性能上甚至高于A100,且提供RT 核心,可以用于实时光线追踪。

GH200和GH200NVL则将使用基于 Arm 的 CPU 和 Hopper 解决大型语言模型的训练和推理问题。相比之下,GH200NVL采用了NVL技术,具有更好的数据传输速度。

英伟达也加快了新品推出的速度。通过产品名称可以看出,“B”系列GPU也有望在2024年下半年推出,替代之前的第九代GPU Hopper。此外,有报道称英伟达下一代GPU产品代号为Blackwell。

英伟达计划推出用基于x86架构的B100接替H200;计划用基于ARM架构的推理芯片GB200替代 GH200。此外,英伟达也规划了B40产品来替代L40S,以提供更好的面向企业客户的AI推理解决方案。

而2025年的X系列,可能是一个代号,取代Blackwell GPU。从A100到H100,英伟达用了2年时间,H200也只是H100基于同一款hopper架构的更新产品,但BlackwellGPU和代号为x的新一代架构GPU按规划达到了一年出一款新产品的速度。

在网络方面,Infiniband 和以太网都将于 2024 年从 400Gbps 发展到 800Gbps,然后在 2025 年达到 1.6Tbps。

不过,英伟达在以太网上并不具有优势,Broadcom的2022-2023系列就有了800G系列,英伟达相对慢了一步。

可以看到,英伟达正加快了产品迭代更新速度,且增加了面向数据中心、HPCGPU的产品细分程度,让不同客户能选择更适合的产品。

扫码下载app 最新资讯实时掌握

扫码下载app 最新资讯实时掌握