AI,AI,AI从年初喊到年尾,说实话,除了用AI办工工具来摸鱼外,这两个字母似乎并没有掀起什么波澜。不过就在这个双11期间,估计会有不少人穿上AI设计的衣服。第一眼看上去,是两个漂亮的模特在T台上展示国风毛衣。但如果仔细看,就会发现一些不同,比如多出来的一双手和台下观众极度扭曲的面部,非常吓人。目前在电商平台上,利用AI技术来生成模特已经不是个例,只要随便一搜国风毛衣的关键词,就会出现一堆类似的唯美的模特上身图。当然,不只是模特,附着在这些模特上的衣服也是由AI生成的。话又说回来,这些衣服实际上身好看吗?

AI国风毛衣,翻车潜力巨大

在AI模特的助攻下,不少买家都被国风毛衣吸引,不少店家的月销量都在百件以上。

但在收到毛衣后,台上古风古韵的郡主,俨然变成了被人使唤的宫女。不仅色差大,在材质和配饰上,现实版和AI展示的衣服都有着巨大的差异。

随着吐槽越来越多,这些买家已经被网友戏称为“第一批国风毛衣裙受害者”,虽说买家和AI模特有差别,但色差过大和版型上的不同,才是让国风毛衣不接地气的原因。

接近真人的AI是怎样练成的?

为了探究现在AI作图到底进化到什么地步了,看来只有亲自上阵了。目前流行的AI作图模式有两种,第一种是部署在云算力上的Mid journey,它虽然易用,但扩展性比较差,无法画出定制化的图片。就像大家在饭店吃饭一样,直接点菜,就会做好端上桌,但口味无法进行很大的调整。所以测试的时候就采用了第二种——Stable Diffusion,这是一种可以运行在自己电脑上的AI,因为一切计算都在本地完成,所以就可以用它绘制一些定制的图片。这就跟自己做菜一个道理,只要愿意,你甚至可以做出宫保鸡丁味儿的西红柿鸡蛋。

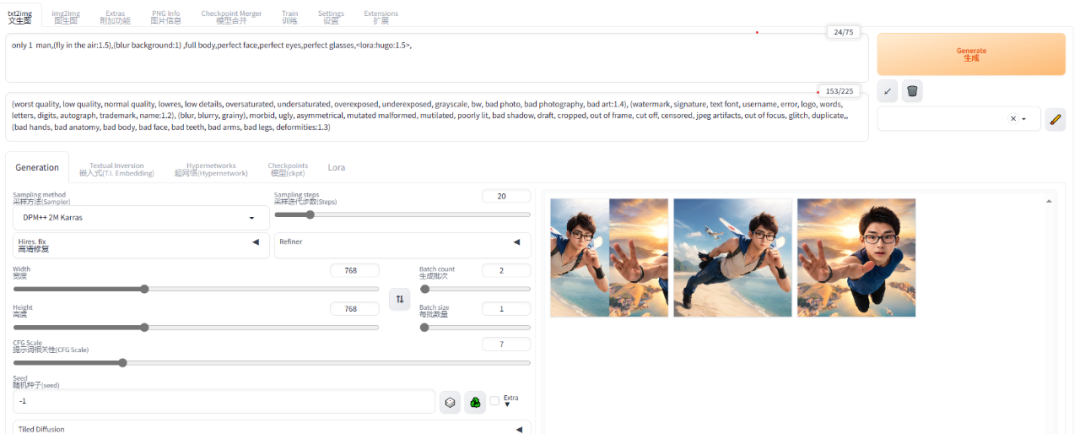

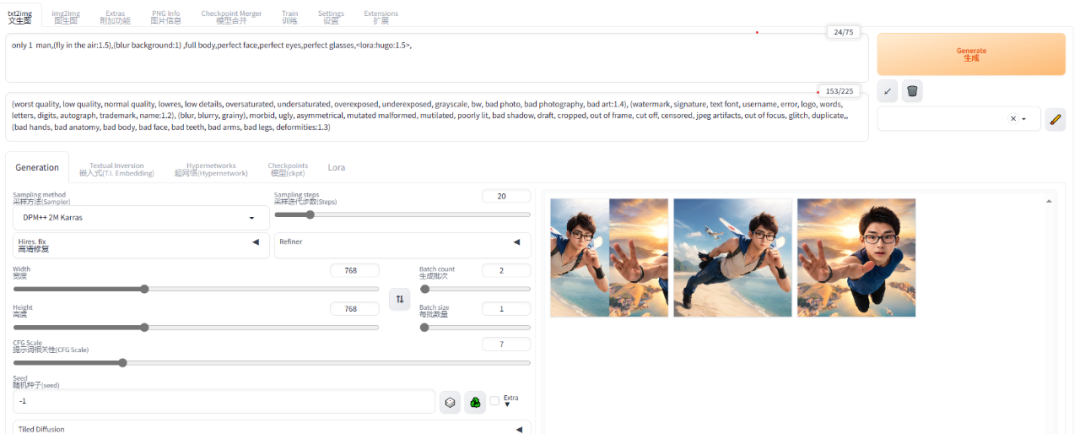

在Stable Diffusion中,AI模型会根据用户给出的关键字,进行绘制。关键字分为两类,一类是你想让画面出现的内容,另一类则是你想避免出现在画面中的内容。所以即使对于AI不熟悉的朋友来讲,作图也不是件难事。Stable Diffusion WebUI 界面所以只需输入:小姐姐,时尚走秀,虚化背景,全身照,汉服,毛衣,国风等一系列提示词,然后在避免出现处,写上像6个手指手部等词语,就可以画出第一批模特了——当当当!请大家欣赏!等下,怎么和电商平台上的不一样啊?难道是提示词的问题?在进行多次尝试后,发现多少还是和卖家图片有差距。潜心研究后,发现是我们用的模型的问题,默认的模型就像什么都会,但又做不好的厨师。我们现在先要吃汉堡,这个厨师能做,但想要好吃,那就难为他了。所以我们现在需要去找一个经过两年半汉堡训练的厨师(模型)。

这下,在输入关键词,我们就可以得到和国风毛衣差不多的图片了!

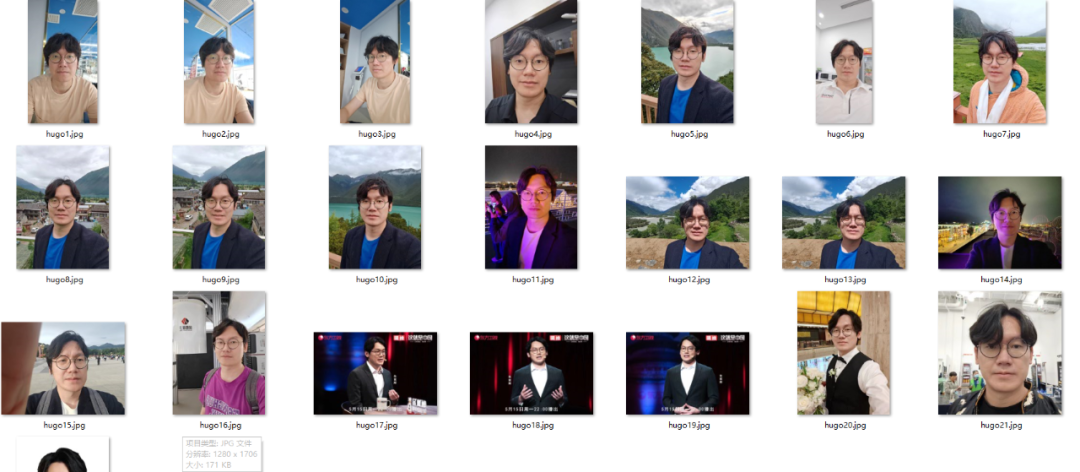

之前我们说过,Stable Diffusion运行在本地电脑上的好处就是可以自己训练,让它做出任何口味的菜(图片),所以到这里,一个大胆的想法出现了——我能训练我自己么?答案是:当然可以。我从手机上随意找了20张自拍,虽然说各个角度都有照片最佳,但是钢铁直男的自拍也不是不能用。经过训练,AI版的我,就这么出来了,这个时候给些关键字或者跟其他模型结合,就可以绘制好多有意思的图片。比如,小鲜肉版本的我,二次元版本的我等等,此时限制我的只有想象力和显卡了(AI计算需要显卡)!

AI给卖家带来了什么?

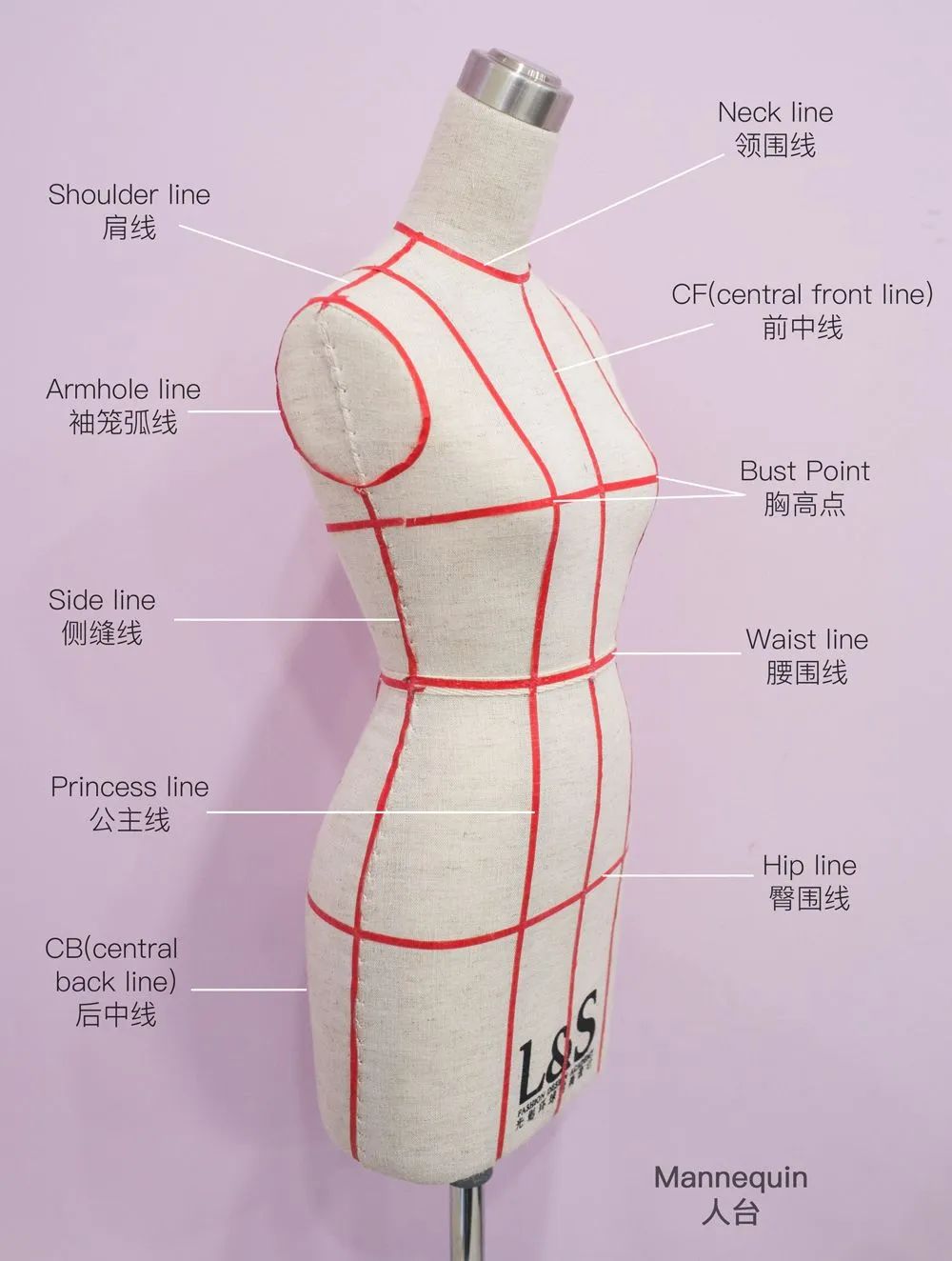

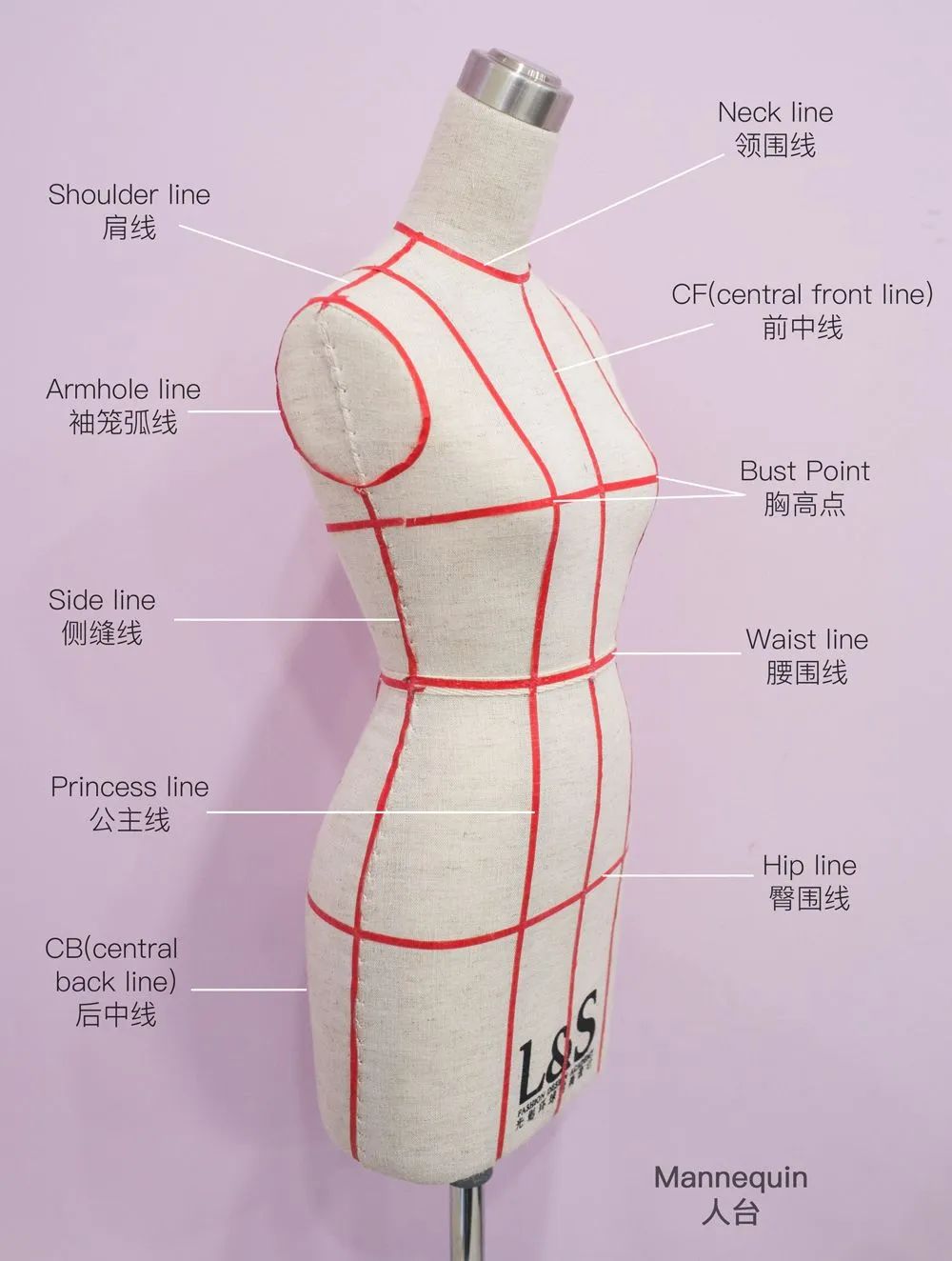

其实目前本地训练的模型不只能做这些,在众多强大的功能下,还可以控制图片里人物的姿势,只要你想,它完全可以做出你想要的动作。那么如此全能的AI给卖家带来了什么呢?这里假设我是一个无良商家。首先,可以肯定的是,免去了请真人模特和拍摄等一系列的费用。其次,也省去了设计,打板,选布料,成衣等一系列步骤。现在我开店,靠着AI生成的图,坐等空手套白狼就可以了。等有顾客下单,照AI画虎做出成品就可以了。但其中省略的打板和选布料两个环节,就造成了前面的色差和版型问题。在传统的制衣过程中,打板是把初步设计好的样品,放在在一个装有假模特上(业内称为人台),确保样品可以符合大部分人的体型。选料则是选出符合设计稿的衣料,比如这次的国风毛衣,用普通的针织衣料肯定会达不到这种飘逸的效果。因为普通的毛线太重,并且还有产生静电,会让裙摆裹在身上,所以想要达到这种效果需要特殊的马海毛才行。也正是因为缺少这两个步骤,才造成了开头的买家秀和卖家秀。

作为消费者,该怎么面对AI

在AI海洋里遨游了几天后,我发现其实目前大部分卖家使用的还都是比较基础的模型。所以对于消费者来讲,现阶段想要分清AI还是实拍不是件难事。因为AI作图在文字,观众脸部等细节上还不够精准,所以AI生成的图片在这三个地方会有很大的瑕疵,大家可以多注意注意。再就是基础模型的油画感很重,多看几张,就会觉得和实拍有很大的不同,另外AI生成高分辨率图片需要高端显卡才可以,所以也可以看下店家的照片是否清晰。

人间一天,AI一年

还记得3月份第一次接触Stable Diffusion的时候,可供下载的模型没有几个,大家还都是以基础模型为主,没想刚刚进入11月份,目前网上的模型已经挑花眼了。有的用户使用各种二次元漫画来训练出漫画风的模型,有的用户则会训练出科幻的模型,因此,现在的模型数量基本上可以覆盖到绝大部分的画图领域了。既然如此,那肯定也有用真人的照片来训练模型吧?答案是肯定的,大家可以猜猜下面这六张图片中,哪几张是AI生成的,哪些是实际拍摄的?(前10名猜中的朋友将获得酷玩赠出的小礼品)相信大家很难辨认出这些图片的真假,这也是为什么上面提到的卖家只是使用了基础的模型,并没有使用定制的模型。因为现在的AI制图确实已经可以达到以假乱真的地步了,如果有人采集大量的模特实拍图用来训练模型,那么卖家秀的区分难度将再上一个量级。这主要是AI学东西太快了,以前人类学习一种风格可能需要几周的时间,而现在只要你有一张足够强力的显卡,AI一天就可以学习完几百张图片。然后把它应用到绘制图片中。这种快,不仅体现在作图上,今天Gen2宣布,它们已经可以生成4K清晰度的视频了,这两天各种郭德纲说外语,霉霉说中文也是最好的作证。真可谓,人间一天,AI一年。就在现在,几万张显卡组成的集群就在地球上很多个角落疯狂的学习,这将带来怎么样的改变,真是让人类又害怕又期待。

扫码下载app 最新资讯实时掌握

扫码下载app 最新资讯实时掌握

扫码下载app 最新资讯实时掌握

扫码下载app 最新资讯实时掌握