今日凌晨,月之暗面发布最新论文《Muon is Scalable for LLM Training》,并开源了MoE模型Moonlight( MIT 许可证),模型激活参数仅需3B。

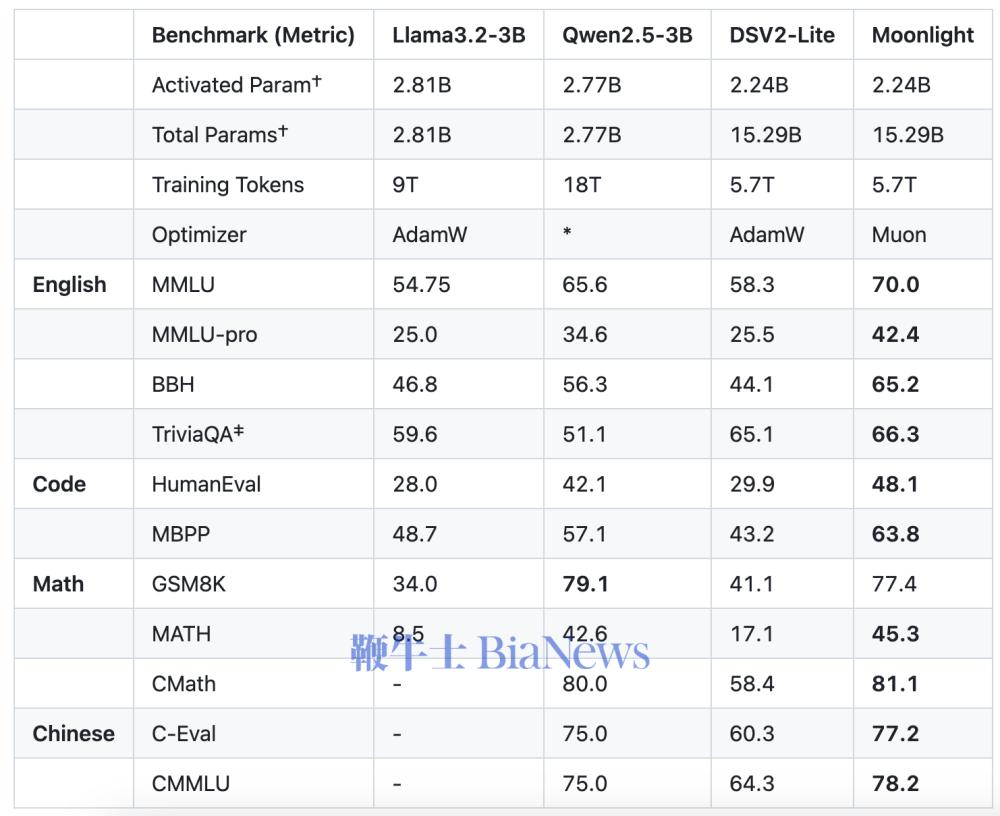

论文显示,月之暗面通过深度改造Muon优化器并将其运用于实际训练,证明了Muon在更大规模训练中的有效性,是AdamW训练效率的2倍且模型性能相当。Moonlight 3B/16B MoE 模型使用 Muon 在 5.7 T token上进行训练,“以更少的 FLOP 和更好的性能推进帕累托前沿。”

月之暗面此次贡献主要在于:

![[转圈]](http://img2.bianews.com/image/bianews/news/img/1740290342038.gif) Muon 有效扩展分析:月之暗面发现权重衰减在Muon的可扩展性中起着至关重要的作用。此外,团队提出通过参数级别更新尺度调整,保持不同矩阵和非矩阵参数之间的一致更新均方根(RMS)。这种调整显著提高了训练稳定性。

Muon 有效扩展分析:月之暗面发现权重衰减在Muon的可扩展性中起着至关重要的作用。此外,团队提出通过参数级别更新尺度调整,保持不同矩阵和非矩阵参数之间的一致更新均方根(RMS)。这种调整显著提高了训练稳定性。![[转圈]](http://img2.bianews.com/image/bianews/news/img/1740290342038.gif) 高效分布式实现:团队开发了一个基于ZeRO-1优化的Muon分布式版本,实现了最佳内存效率并降低了通信开销,同时保持算法的数学特性。

高效分布式实现:团队开发了一个基于ZeRO-1优化的Muon分布式版本,实现了最佳内存效率并降低了通信开销,同时保持算法的数学特性。

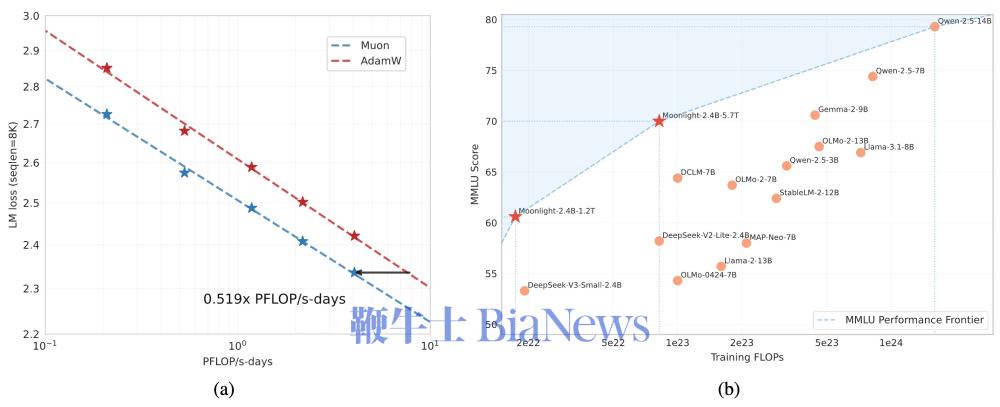

![[转圈]](http://img2.bianews.com/image/bianews/news/img/1740290342038.gif) Scaling Law验证:月之暗面进行了Scaling Law研究,比较了Muon与AdamW的性能,结果显示Muon具有更优的表现。根据Scaling Law结果,Muon在性能上与AdamW训练的对比模型相当,但训练所需FLOP仅约为AdamW的52%。

Scaling Law验证:月之暗面进行了Scaling Law研究,比较了Muon与AdamW的性能,结果显示Muon具有更优的表现。根据Scaling Law结果,Muon在性能上与AdamW训练的对比模型相当,但训练所需FLOP仅约为AdamW的52%。

对于月之暗面深夜发布开源模型的行为,有网友认为是在截胡DeepSeek。2月21日午间,DeepSeek团队在X官方账号发布消息,下周将陆续完全开源5个代码库,为“开源周”(OpenSourceWeek)预热,以完全透明的方式分享研究进展。

目前,Kimi已经不在App Store免费榜前十,前三名为DeepSeek、腾讯元宝和豆包。

(转载自InfoQ)

扫码下载app 最新资讯实时掌握

扫码下载app 最新资讯实时掌握