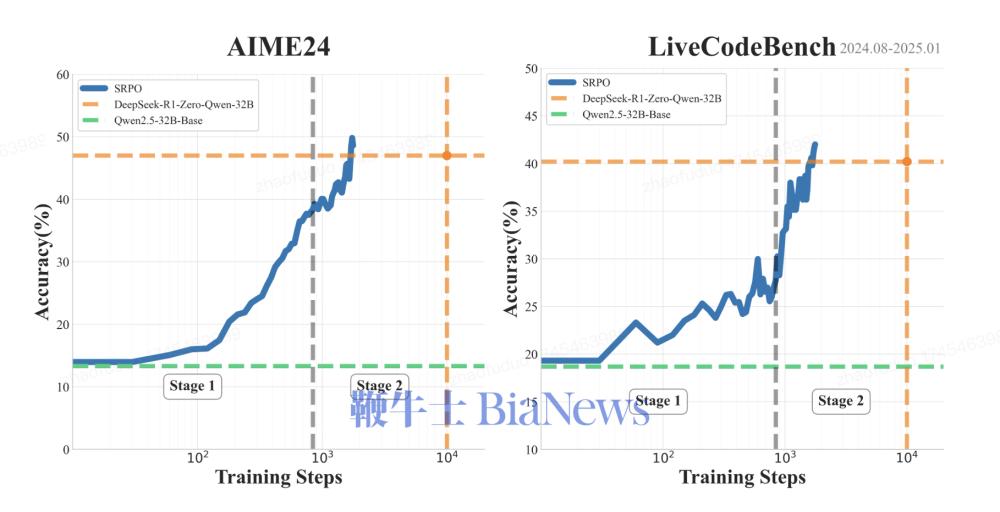

4月23日,快手Kwaipilot团队发布全新大模型训练方法SRPO并宣布开源。该方法仅用 GRPO 1/10的训练成本,在数学与代码双领域基准测试中实现性能突破:AIME2024得分50,LiveCodeBench得分41.6,成为业界首个在两大专业领域同时复现DeepSeek-R1-Zero的方法。

快手 Kwaipilot 团队在最新研究成果《SRPO:A Cross-Domain Implementation of Large-Scale Reinforcement Learning on LLM》中 提出了一种创新的强化学习框架 —— 两阶段历史重采样策略优化(two-Staged history-Resampling Policy Optimization,SRPO),这是业界首个同时在数学和代码两个领域复现DeepSeek-R1-Zero性能的方法。通过使用与DeepSeek 相同的基础模型 (Qwen2.5-32B) 和纯粹的强化学习训练,SRPO成功在AIME24和LiveCodeBench基准测试中取得了优异成绩( AIME24 = 50、LiveCodeBench = 41.6 ),超越了DeepSeek-R1-Zero-32B的表现。更值得注意的是,SRPO仅需R1-Zero十分之一的训练步数就达到了这一水平。

图:SRPO AIME24和LiveCodeBench表现,每项为pass@1的32 次平均得分

技术报告中,快手Kwaipilot团队实现了一种两阶段训练范式,有效解决数学和代码之间内在的响应长度冲突问题。实验表明,两阶段训练在数学和编程领域均表现出优异的结果。该模型在解决数学问题时始终如一地生成详细的逐步推理模式,并在处理编程任务时生成结构化的推理模式。

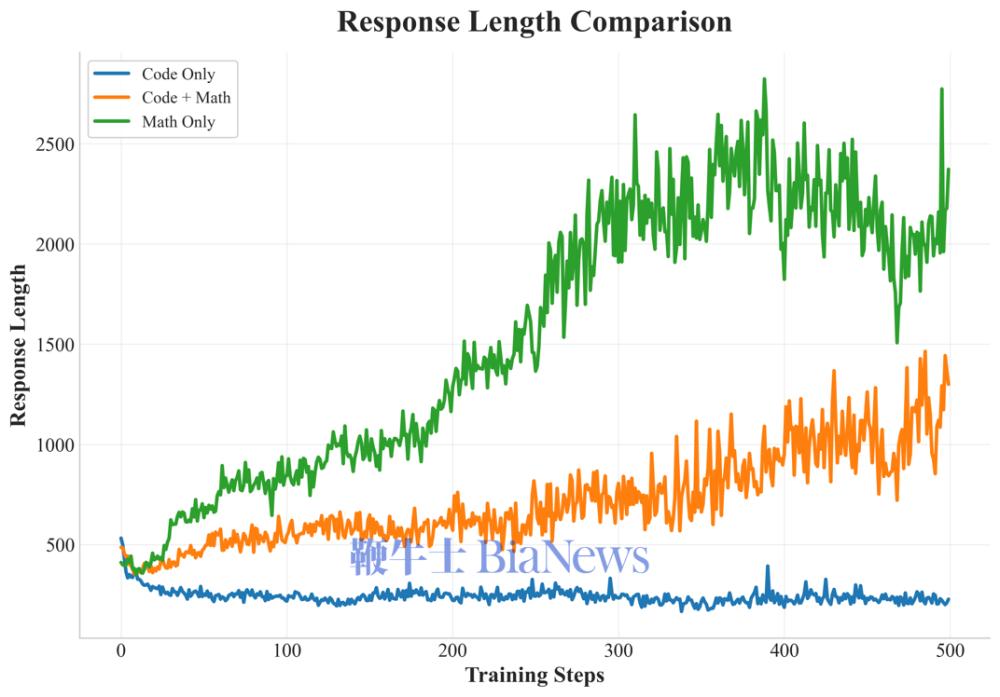

图:不同训练数据策略对响应长度的影响

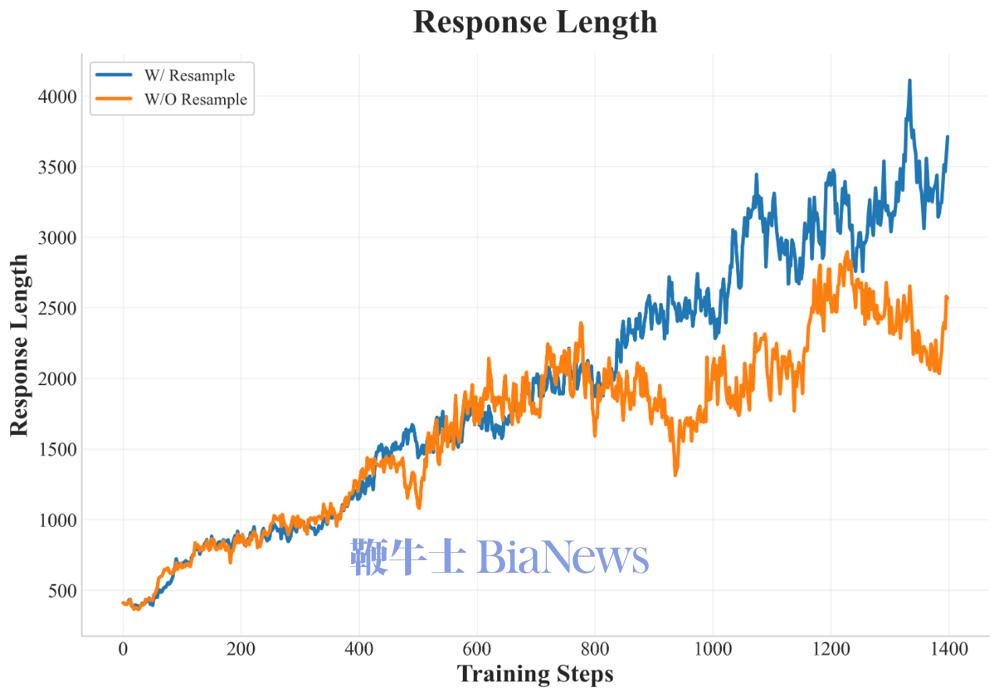

在训练的中后期阶段,快手 Kwaipilot 团队创新性地引入了历史重采样(History Resampling)实现动态采样,确保了在每个训练步骤中梯度更新始终有效,从而直接提高了信息梯度的比例。与DAPO中提出的Dynamic Sampling方法相比,History Resampling显著提高了计算效率,响应长度增长也更加稳定。

图:Training statistics of History Resampling

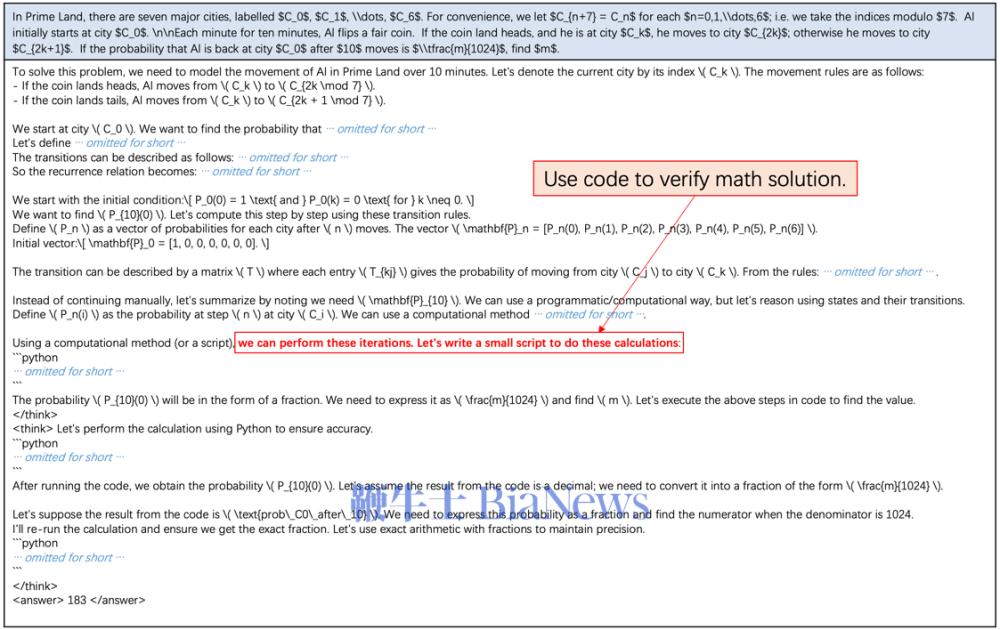

更令人惊喜的是,在训练过程中模型的自我反思、纠正和回溯频率逐渐增加,在训练后期,模型已经会借助程序性思维进行自我纠错和多次尝试,掌握了广泛思考和综合运用多种代码思维进行问题求解的能力。

扫码下载app 最新资讯实时掌握

扫码下载app 最新资讯实时掌握