智谱AI与清华KEG联合开源多模态大模型CogVLM-17B

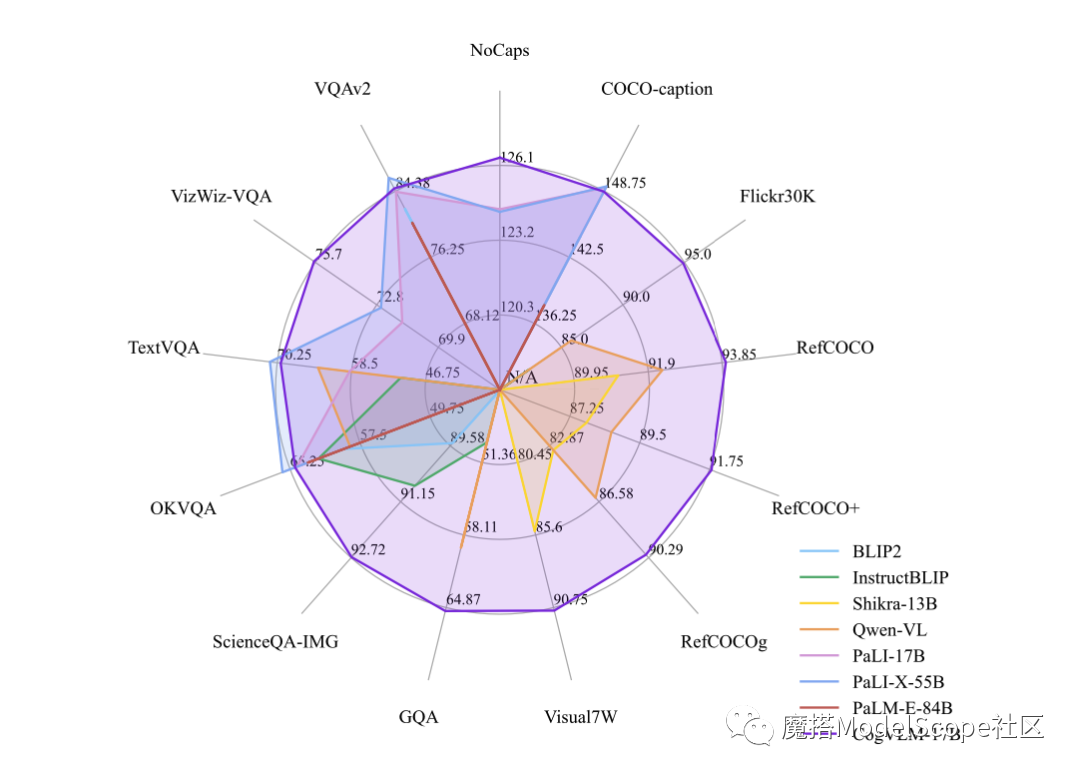

鞭牛士 10月12日消息,近日,智谱AI&清华KEG于魔搭社区发布并直接开源了多模态大模型——CogVLM-17B。据悉,CogVLM是一个强大的开源视觉语言模型,利用视觉专家模块深度整合语言编码和视觉编码,在14项权威跨模态基准上取得了SOTA性能。

CogVLM-17B 是目前多模态权威学术榜单上综合成绩第一的模型,在14个数据集上取得了state-of-the-art或者第二名的成绩,CogVLM的效果依赖于“视觉优先”的思想,即在多模态模型中将视觉理解放在更优先的位置,使用5B参数的视觉编码器和6B参数的视觉专家模块,总共11B参数建模图像特征,甚至多于文本的7B参数量。

扫码下载app 最新资讯实时掌握

扫码下载app 最新资讯实时掌握